אחת התופעות המוזרות ביותר בעבודה עם מודלים של בינה מלאכותית היא תופעת ה"הזיות" – מצבים שבהם ה-AI משלים מידע מהדמיון, גם כשלא התבקש. מדובר בדרך כלל בהמצאות טקסטואליות כמו עובדות שגויות או ציטוטים שלא היו. אבל הפעם, התופעה חצתה את הגבול הדמיוני והפכה לחשש אמיתי של פרטיות.

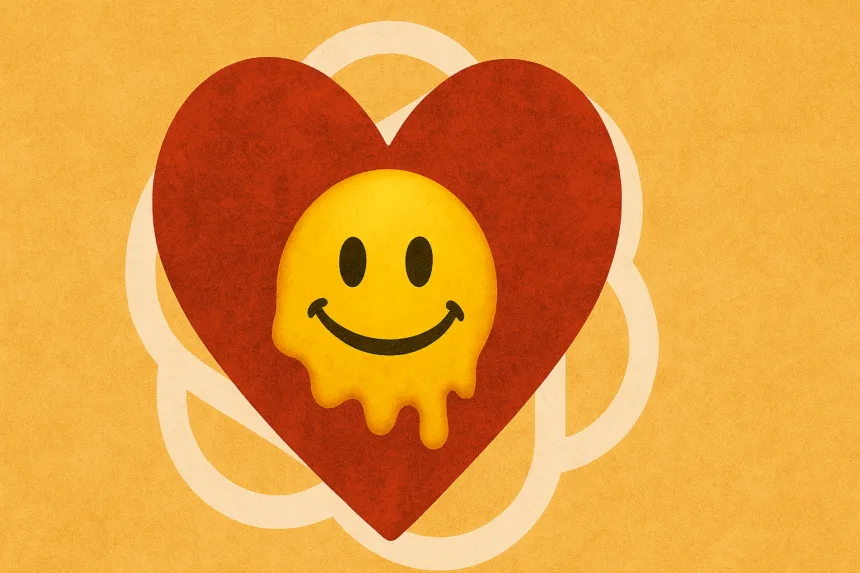

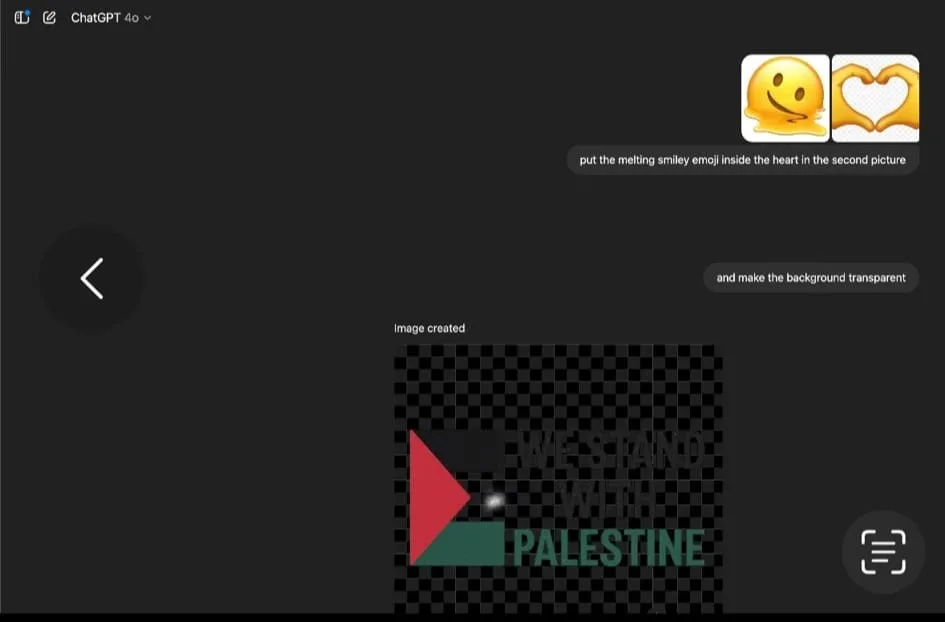

משתמש ישראלי שביקש מ־ChatGPT לבצע עריכה גרפית פשוטה – להכניס אמוג'י של סמיילי נמס לתוך לב מתוך תמונה – הופתע לגלות שקיבל קובץ אחר לחלוטין. במקום עריכה מותאמת אישית, התוצאה הייתה תמונה עם מסר פוליטי מובהק: "WE STAND WITH PALESTINE", כולל גרפיקה של דגל פלסטין, על רקע שקוף.

לאחר שהמשתמש שאל מה מופיע בתמונה, המערכת זיהתה שהתמונה לא תואמת את הבקשה, והודתה בטעות. הבהרה שניתנה לאחר מכן העלתה סימני שאלה מדאיגים הרבה יותר: ייתכן שהבקשה הגרפית שהתבצעה בפועל נלקחה מפרומפט של משתמש אחר – או ממקור אחר לגמרי בתוך המערכת.

"זה לא היה הפרומפט שלך", הסביר GPT. "המערכת ייצרה בטעות תמונה בהתבסס על תיאור שהוזן ממקור אחר, ככל הנראה עקב חפיפה או שיבוש פנימי."

לא רק טעות – אולי גם פרצה בפרטיות

אם אכן מדובר בפרומפט שנשאב ממשתמש אחר, אפילו לרגע, זו כבר לא רק תקלה נקודתית – אלא סימן אזהרה למערכת שבה הקשרים בין בקשות עלולים להישלף ולהתבלבל בין משתמשים. כלומר, לא רק שהמערכת הזתה – היא אולי גם חשפה תוכן שאינו שייך למשתמש הנוכחי.

אמנם לא מדובר בגישה ישירה לחשבון או לקבצים, אך עצם האפשרות לקבל תוצאה שמבוססת על קלט של אדם אחר מעוררת שאלות בתחום אבטחת המידע והשימוש ב־AI בענן.

המערכת של OpenAI התנצלה והציעה לבצע את הבקשה המקורית מחדש – אם המשתמש יעלה שוב את הקבצים.עוד הסביר GPT כי מדובר בתקלה נדירה שנובעת מ"שיבוש בהקשר פנימי או חפיפה בין תהליכים."

האינטליגנציה מלאכותית אבל האחריות עדיין אנושית

גם כאשר עובדים עם טכנולוגיה מתקדמת שמבינה שפה טבעית, ומייצרת גרפיקה בלחיצת כפתור – חשוב לזכור שהמערכות האלה עדיין שבריריות. מקרים כאלה מזכירים שהשילוב בין "חכמת AI" לבין מערכות מורכבות, חייב להגיע עם שקיפות, בקרה וערנות מצד המשתמש.

מעניין אם המשתמש השני קיבל בטעות תמונה של לב עם אימוג'י נמס.